編者按:2025 年 11 月 13 日,安謀科技(Arm China)“周易”X3 NPU IP新品。作為“All in AI”產品戰略下誕生的首款重磅產品,其性能指標表現突出:8-80 FP8 TFLOPS、單Core帶寬256GB/s、Prefill算力利用率達72%和Decode有效帶寬利用率超100%,可使AIGC大模型能力提升10倍。

隨著AI大模型技術的飛速發展,智能手機、AI PC和智能汽車等端側設備正迎來AI能力的爆發性需求。從多模態語音助手到實時圖像生成,從智能座艙交互到輔助駕駛決策,端側設備需要承載越來越復雜的AI計算任務。

然而,端側AI部署面臨算力受限、能效要求高、帶寬瓶頸、開發門檻高等多重挑戰,如何在有限的功耗和算力資源下實現大模型的高效運行,成為行業亟需突破的關鍵難題。

眾所周知,在半導體領域,“面向未來5年的產品方向進行前瞻布局”已成為行業共識,涵蓋IP研發、芯片及終端產品研發量產。

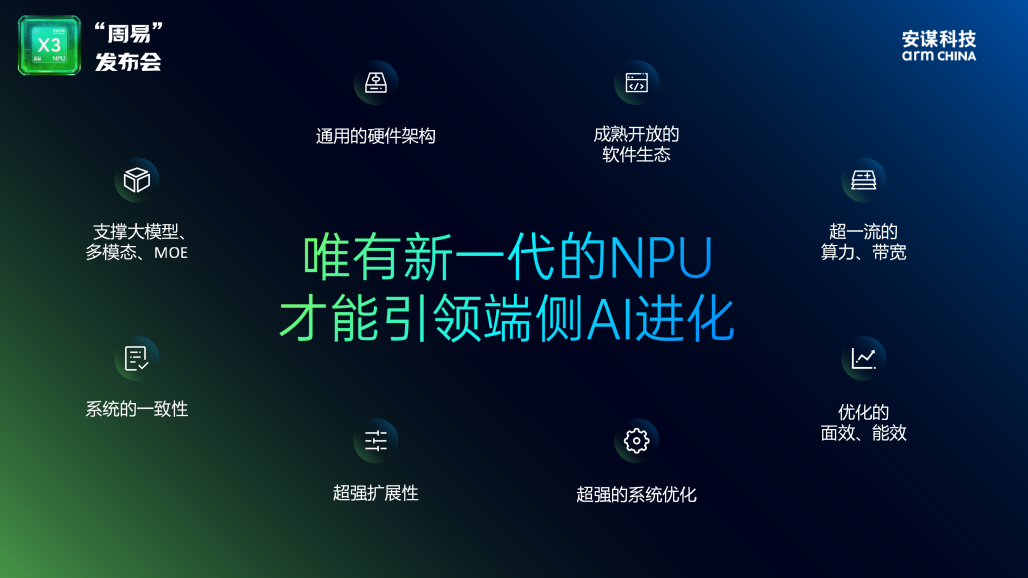

因需而動,安謀科技的“周易”X3采用兼顧CNN與Transformer的通用架構設計,支持全算力類型并增強浮點運算FLOPS,助力實現從定點到浮點計算的關鍵轉變,并滿足大模型計算需求,為未來5年Gen AI、Agentic AI與Physical AI的端側落地奠定技術基石。

硬件架構:專為大模型設計最新DSP+DSA架構

“周易”X3基于專為大模型設計的最新DSP+DSA架構,從計算效率、帶寬、精度適配、任務處理四大維度實現升級,精準解決端側AI大模型運行難題,打造端側AI計算效率的新標桿。

從定點轉向浮點計算,單Cluster擁有8-80 FP8 TFLOPS算力且可靈活配置,單Core帶寬高達256GB/s,支持端側大模型運行必備的W4A8/W4A16計算加速模式,集成安謀科技自研的解壓硬件WDC,使大模型Weight軟件無損壓縮后通過硬件解壓獲得額外約15%的等效帶寬,計算效率和計算密度大幅提升。

同時,“周易”X3集成AI專屬硬件引擎AIFF,配合專用硬化調度器,實現超低至0.5%的CPU負載與低調度延遲,使NPU在并行處理多項AI任務時,擁有高效流暢的體驗。

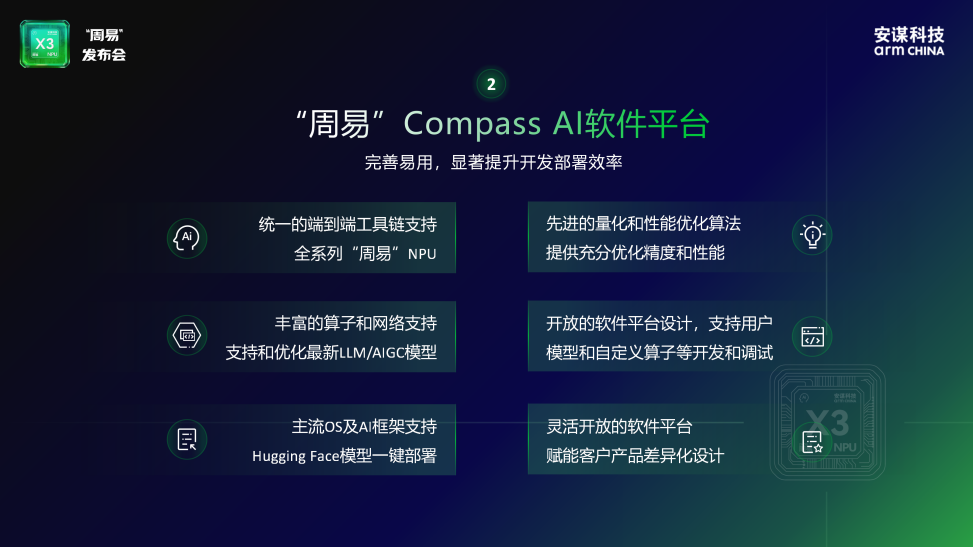

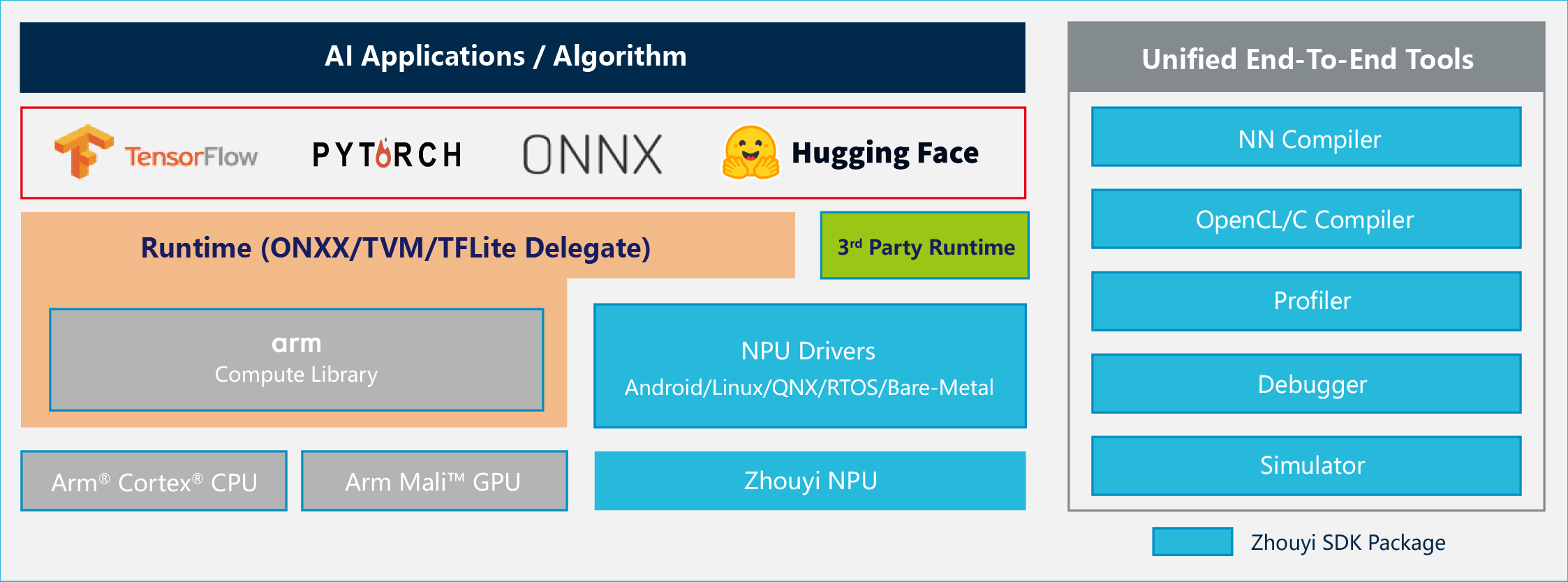

軟件生態:優化大模型端到端性能,支持客戶自定義AI開發

“周易”X3 搭載完善易用的Compass AI軟件平臺,全面優化大模型端到端性能。平臺廣泛兼容TensorFlow、ONNX、PyTorch等主流AI框架,具備業界領先的大模型動態Shape支持能力,并支持GPTQ等大模型主流量化方案、 Hugging Face模型庫,與LLM、VLM、VLA及MoE等模型。

同時,安謀科技積極構建開放生態,Compass AI軟件平臺已將 Parser、Optimizer、Linux Driver、TVM 及內部 IR 格式等核心組件相繼開源,并擁有豐富的調試工具,可滿足開發者白盒部署需求,且支持更易用的 DSL 算子編程語言,在深度開發模式下,客戶可以使用平臺中的Compiler、Debugger和DSL語言開發出自己的自定義算子,也可通過Parser、Optimizer等工具打造出屬于自己的模型編譯器,極大提升開發效率。

“周易”Compass AI軟件平臺已支持超 160 種算子與 270 多種模型,顯著提升開發部署效率,助力客戶快速實現 AI 應用創新與落地。

性能提升:讓端側大模型“跑得穩、答得順”

“周易”X3遵循“軟硬協同、全周期服務與成就客戶”的產品準則,提供從硬件、軟件到售后服務的全鏈路支持,以前瞻性設計、專業團隊交付與深度服務投入,全面助力客戶大模型產品成功與商業化落地。

“周易”X3在架構層面實現了多項創新,集成了業界矚目的關鍵特性。

1.集成自研解壓硬件WDC:使大模型Weight軟件無損壓縮后通過硬件解壓能獲得額外15%~20%等效帶寬提升。

2.新增端側大模型運行必備的W4A8/W4A16計算加速模式:對模型權重進行低比特量化,大幅降低帶寬消耗,支持云端大模型向端側的高效遷移。

3.集成AI專屬硬件引擎AIFF(AI Fixed-Function)與專用硬化調度器:實現超低至0.5%的CPU負載與低調度延遲,靈活支持端側多任務場景和任意優先級調度場景,確保高優先級任務的即時響應。

4.支持int4/int8/int16/int32/fp4/fp8/fp16/bf16/fp32多精度融合計算,強浮點計算:可靈活適配智能手機邊緣部署、AI PC推理、智能汽車等從傳統CNN到前沿大模型的數據類型需求,平衡性能與能效。

在上述關鍵技術的加持下,“周易”X3獲得了優異的計算性能:單Cluster最高支持4個Core,擁有8-80 FP8 TFLOPS算力且可靈活配置,單Core帶寬高達256GB/s。相較于“周易”X2產品,“周易”X3的CNN模型性能提升30%-50%,多核算力線性度達到70%-80%。在同算力規格下,AIGC大模型能力較上一代產品實現10倍增長,這得益于16倍的FP16 TFLOPS、4倍的計算核心帶寬、超過10倍的Softmax和LayerNorm性能提升共同驅動。

借助“周易”X3的超能力,端側大模型推理將更高效。

實測結果表明,在Llama2 7B大模型實測中,“周易”X3 NPU IP在Prefill階段算力利用率高達72%,并在安謀科技Arm China自研的解壓硬件WDC的加持下,實現Decode階段有效帶寬利用率超100%,遠超行業平均水平,滿足大模型解碼階段的高吞吐需求。

總結

“周易”X3 NPU IP的發布,標志著安謀科技Arm China“All in AI”產品戰略的正式開啟。從“周易”Z1的基礎感知到“周易”X3的復雜認知,這一技術演進路徑清晰地表明,端側AI正在從單一的功能實現,邁向融合多種模型、適應動態場景的“全民普及”新階段