ChatGPT的技術(shù)體系

0.參考資料

RLHF論文:Training language models to follow instructions with human feedback(https://arxiv.org/pdf/2203.02155.pdf)

摘要上下文中的 RLHF:Learning to summarize from Human Feedback (https://arxiv.org/pdf/2009.01325.pdf)

PPO論文:Proximal Policy Optimization Algorithms(https://arxiv.org/pdf/1707.06347.pdf)

Deep reinforcement learning from human preferences (https://arxiv.org/abs/1706.03741)

1. 引言

1.1 ChatGPT的介紹

作為一個 AI Chatbot,ChatGPT 是當(dāng)前比較強大的自然語言處理模型之一,它基于 Google 的 T5 模型進行了改進,同時加入了許多自然語言處理的技術(shù),使得它可以與人類進行自然的、連貫的對話。ChatGPT 使用了 GPT(Generative Pre-training Transformer)架構(gòu),它是一種基于 Transformer 的預(yù)訓(xùn)練語言模型。GPT 的主要思想是將大量的語料庫輸入到模型中進行訓(xùn)練,使得模型能夠理解和學(xué)習(xí)語言的語法、語義等信息,從而生成自然、連貫的文本。與其他 Chatbot 相比,ChatGPT 的優(yōu)勢在于它可以進行上下文感知型的對話,即它可以記住上下文信息,而不是簡單地匹配預(yù)先定義的規(guī)則或模式。此外,ChatGPT 還可以對文本進行生成和理解,支持多種對話場景和話題,包括閑聊、知識問答、天氣查詢、新聞閱讀等等。

盡管 ChatGPT 在自然語言處理領(lǐng)域已經(jīng)取得了很好的表現(xiàn),但它仍然存在一些局限性,例如對于一些復(fù)雜的、領(lǐng)域特定的問題,它可能無法給出正確的答案,需要通過人類干預(yù)來解決。因此,在使用 ChatGPT 進行對話時,我們?nèi)孕枰?jǐn)慎對待,盡可能提供明確、簡潔、準(zhǔn)確的問題,以獲得更好的對話體驗。

1.2 ChatGPT的訓(xùn)練模式

ChatGPT 的訓(xùn)練模式是基于大規(guī)模文本數(shù)據(jù)集的監(jiān)督學(xué)習(xí)和自我監(jiān)督學(xué)習(xí),這些數(shù)據(jù)集包括了各種類型的文本,例如新聞文章、博客、社交媒體、百科全書、小說等等。ChatGPT 通過這些數(shù)據(jù)集進行預(yù)訓(xùn)練,然后在特定任務(wù)的數(shù)據(jù)集上進行微調(diào)。

對于 Reinforcement Learning from Human Feedback 的訓(xùn)練方式,ChatGPT 通過與人類進行對話來進行模型訓(xùn)練。具體而言,它通過與人類進行對話,從而了解人類對話的語法、語義和上下文等方面的信息,并從中學(xué)習(xí)如何生成自然、連貫的文本。當(dāng) ChatGPT 生成回復(fù)時,人類可以對其進行反饋,例如“好的”、“不太好”等等,這些反饋將被用來調(diào)整模型參數(shù),以提高 ChatGPT 的回復(fù)質(zhì)量。Reinforcement Learning from Human Feedback 的訓(xùn)練方式,可以使 ChatGPT 更加智能,更好地模擬人類的思維方式。不過這種訓(xùn)練方式也存在一些問題,例如人類反饋的主觀性和不確定性等,這些問題可能會影響模型的訓(xùn)練效果。因此,我們需要在使用 ChatGPT 進行對話時,謹(jǐn)慎對待反饋,盡可能提供明確、簡潔、準(zhǔn)確的反饋,以獲得更好的對話體驗。

1.3 RLHF的介紹

在過去的幾年中,語言模型通過根據(jù)人類輸入提示生成多樣化且引人注目的文本顯示出令人印象深刻的能力。然而,什么才是“好”文本本質(zhì)上很難定義,因為它是主觀的并且依賴于上下文。有許多應(yīng)用程序,例如編寫您需要創(chuàng)意的故事、應(yīng)該真實的信息性文本片段,或者我們希望可執(zhí)行的代碼片段。編寫一個損失函數(shù)來捕獲這些屬性似乎很棘手,而且大多數(shù)語言模型仍然使用簡單的下一個loss function(例如交叉熵)進行訓(xùn)練。為了彌補損失本身的缺點,人們定義了旨在更好地捕捉人類偏好的指標(biāo),例如 BLEU 或 ROUGE。雖然比損失函數(shù)本身更適合衡量性能,但這些指標(biāo)只是簡單地將生成的文本與具有簡單規(guī)則的引用進行比較,因此也有局限性。如果我們使用生成文本的人工反饋作為性能衡量標(biāo)準(zhǔn),或者更進一步并使用該反饋作為損失來優(yōu)化模型,那不是很好嗎?這就是從人類反饋中強化學(xué)習(xí)(RLHF)的想法;使用強化學(xué)習(xí)的方法直接優(yōu)化帶有人類反饋的語言模型。RLHF 使語言模型能夠開始將在一般文本數(shù)據(jù)語料庫上訓(xùn)練的模型與復(fù)雜人類價值觀的模型對齊。

在傳統(tǒng)的強化學(xué)習(xí)中,智能的agent需要通過不斷的試錯來學(xué)習(xí)如何最大化獎勵函數(shù)。但是,這種方法往往需要大量的訓(xùn)練時間和數(shù)據(jù),同時也很難確保智能代理所學(xué)習(xí)到的策略是符合人類期望的。Deep Reinforcement Learning from Human Preferences 則采用了一種不同的方法,即通過人類偏好來指導(dǎo)智能代理的訓(xùn)練。具體而言,它要求人類評估一系列不同策略的優(yōu)劣,然后將這些評估結(jié)果作為訓(xùn)練數(shù)據(jù)來訓(xùn)練智能代理的深度神經(jīng)網(wǎng)絡(luò)。這樣,智能代理就可以在人類偏好的指導(dǎo)下,學(xué)習(xí)到更符合人類期望的策略。除了減少訓(xùn)練時間和提高智能代理的性能之外,Deep Reinforcement Learning from Human Preferences 還可以在許多現(xiàn)實場景中發(fā)揮作用,例如游戲設(shè)計、自動駕駛等。通過使用人類偏好來指導(dǎo)智能代理的訓(xùn)練,我們可以更好地滿足人類需求,并創(chuàng)造出更加智能和人性化的技術(shù)應(yīng)用

2. 方法介紹

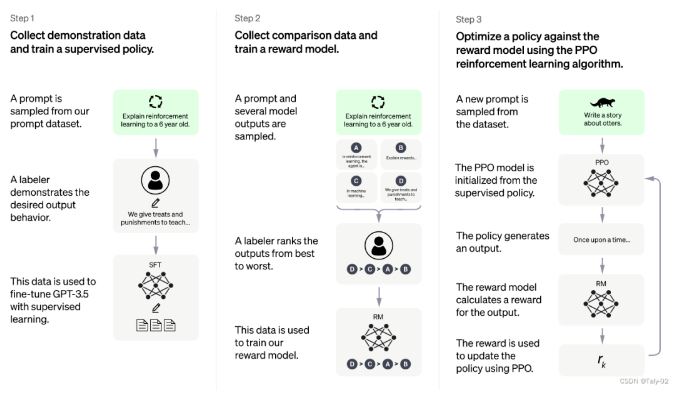

方法總體上包括三個不同步驟:

監(jiān)督調(diào)優(yōu)模型:在一小部分已經(jīng)標(biāo)注好的數(shù)據(jù)上進行有監(jiān)督的調(diào)優(yōu),讓機器學(xué)習(xí)從一個給定的提示列表中生成輸出,這個模型被稱為 SFT 模型。

模擬人類偏好,讓標(biāo)注者們對大量 SFT 模型輸出進行投票,這樣就可以得到一個由比較數(shù)據(jù)組成的新數(shù)據(jù)集。然后用這個新數(shù)據(jù)集來訓(xùn)練一個新模型,叫做 RM 模型。

用 RM 模型進一步調(diào)優(yōu)和改進 SFT 模型,用一種叫做 PPO 的方法得到新的策略模式。

第一步只需要進行一次,而第二步和第三步可以持續(xù)重復(fù)進行,以收集更多的比較數(shù)據(jù)來訓(xùn)練新的 RM 模型和更新策略模式。

2.1 監(jiān)督調(diào)優(yōu)模型

需要收集數(shù)據(jù)來訓(xùn)練有監(jiān)督的策略模型。為了做到這一點,選定一些提示,讓標(biāo)注人員寫出預(yù)期的回復(fù)。這個過程雖然緩慢和昂貴,但最終得到的是一個相對較小、高質(zhì)量的數(shù)據(jù)集,可用于調(diào)優(yōu)預(yù)訓(xùn)練的語言模型。選擇了 GPT-3.5 系列中的預(yù)訓(xùn)練模型作為基線模型,而不是對原始 GPT-3 模型進行調(diào)優(yōu)。

然而,由于此步驟的數(shù)據(jù)量有限,這個過程得到的 SFT 模型可能會輸出一些不是用戶想要的文本,通常也會出現(xiàn)不一致問題。為了解決這個問題,使用的策略是讓標(biāo)注者對 SFT 模型的不同輸出進行排序以創(chuàng)建 RM 模型,而不是讓標(biāo)注者創(chuàng)建一個更大的精選數(shù)據(jù)集。

2.2 訓(xùn)練回報模型

在這一步中,我們的目標(biāo)是學(xué)習(xí)一個目標(biāo)函數(shù),它可以直接從數(shù)據(jù)中學(xué)習(xí),而不是僅僅從有限的訓(xùn)練數(shù)據(jù)中調(diào)整語言模型。這個目標(biāo)函數(shù)的作用是為 SFT 模型生成的輸出進行評分,以表示這些輸出對人類來說有多可接受。它反映了人類標(biāo)注者的偏好和共同準(zhǔn)則。最終,這個過程可以得到一個系統(tǒng),它可以模仿人類的偏好。包括以下步驟:

利用prompt 生成多個輸出。

利用標(biāo)注者對這些輸出進行排序,獲得一個更大質(zhì)量更高的數(shù)據(jù)集。

把模型將 SFT 模型輸出作為輸入,并按優(yōu)先順序?qū)λ鼈冞M行排序。

2.3 使用 PPO 模型微調(diào) SFT 模型

這一步的目標(biāo)是通過強化學(xué)習(xí)來調(diào)整 SFT 模型。具體來說,使用了一個叫 PPO 的算法來訓(xùn)練一個叫做近端策略優(yōu)化模型的調(diào)整模型,用于優(yōu)化 SFT 模型。

PPO 是一種用于訓(xùn)練智能體的算法,可以不斷地調(diào)整策略以提高效果。與其他算法不同的是,PPO 會限制策略的更改范圍,以確保訓(xùn)練的穩(wěn)定性。此外,PPO 還使用了一個價值函數(shù)來估計每個行動的價值,從而更加準(zhǔn)確地進行調(diào)整。

在這一步中,PPO 模型使用 SFT 模型作為起點,RM 模型作為基礎(chǔ),為給定的輸入生成回報。為了避免過度優(yōu)化,SFT 模型會為每個 token 添加 KL 懲罰因子。

3. 性能評估

作為一個大型語言模型,ChatGPT的評估標(biāo)準(zhǔn)可以有多種。在訓(xùn)練ChatGPT時,通常會使用一些標(biāo)準(zhǔn)的自然語言處理評估指標(biāo)來評估其性能,如困惑度(perplexity)、BLEU分?jǐn)?shù)、ROUGE分?jǐn)?shù)等。這些指標(biāo)可以用來評估ChatGPT在生成文本時的流暢度、語義連貫性和表達能力等方面的表現(xiàn)。此外,ChatGPT也可以通過人類評估來評估其性能,例如進行用戶調(diào)查或人類評分實驗。這些方法可以提供更貼近實際使用場景的評估,以便更全面地評估ChatGPT在生成自然語言文本方面的表現(xiàn)。

主要借助以下三個標(biāo)準(zhǔn)進行評估:

幫助性:判斷模型遵循用戶指示以及推斷指示的能力。

真實性:判斷模型在封閉領(lǐng)域任務(wù)中有產(chǎn)生虛構(gòu)事實的傾向。

無害性:標(biāo)注者評估模型的輸出是否適當(dāng)、是否包含歧視性內(nèi)容。

4. ChatGPT的前景

ChatGPT 在自然語言處理領(lǐng)域具有廣泛的應(yīng)用前景。它可以用于語言翻譯、情感分析、問答系統(tǒng)、文本摘要、對話系統(tǒng)等多個任務(wù),幫助人們更好地理解和處理自然語言。此外,ChatGPT 還可以應(yīng)用于許多其他領(lǐng)域,例如自然語言生成、自動文本摘要、機器翻譯、自動問答、語音識別等。它也可以用于推薦系統(tǒng)、智能客服、智能問答、知識圖譜等領(lǐng)域。ChatGPT 的未來發(fā)展前景非常廣闊,可以預(yù)見的是,隨著技術(shù)的不斷發(fā)展,它將在各個領(lǐng)域得到更廣泛的應(yīng)用和改進。同時,也需要關(guān)注和解決一些挑戰(zhàn),例如如何提高模型的效率和準(zhǔn)確性,如何解決對話中的常識推理和知識不足等問題。

更多信息可以來這里獲取==>>電子技術(shù)應(yīng)用-AET<<