摘 要: 邏輯模型樹(shù)(LMT)算法是基于樹(shù)歸納和邏輯回歸的一種分類算法。為驗(yàn)證LMT算法的優(yōu)勢(shì),利用3個(gè)UCI標(biāo)準(zhǔn)數(shù)據(jù)集建模,將LMT算法與其他決策樹(shù)方法進(jìn)行對(duì)比分析。針對(duì)LMT算法在建立邏輯回歸模型時(shí)會(huì)導(dǎo)致較高的計(jì)算復(fù)雜性的問(wèn)題,研究利用赤池信息量準(zhǔn)則改進(jìn)LMT算法,提升算法時(shí)間性能,避免模型過(guò)度擬合。在UCI標(biāo)準(zhǔn)數(shù)據(jù)集和煙葉綜合質(zhì)量評(píng)價(jià)數(shù)據(jù)中應(yīng)用改進(jìn)的LMT算法進(jìn)行建模驗(yàn)證,結(jié)果表明,該改進(jìn)方法在模型精度和召回率方面基本優(yōu)于其他決策樹(shù)方法,時(shí)間性能比改進(jìn)前提升50%左右,能較好地評(píng)價(jià)煙葉綜合質(zhì)量。

關(guān)鍵詞: 邏輯模型樹(shù);UCI標(biāo)準(zhǔn)數(shù)據(jù)集;煙葉綜合質(zhì)量評(píng)價(jià)數(shù)據(jù);赤池信息量準(zhǔn)則;模型精度;召回率

0 引言

決策樹(shù)分類法是一種簡(jiǎn)單而廣泛使用的分類技術(shù),是數(shù)據(jù)挖掘分類算法的一個(gè)重要方法,可以用于分析數(shù)據(jù),同樣也可以用作預(yù)測(cè)。決策樹(shù)法作為一種決策技術(shù),已被廣泛地應(yīng)用于企業(yè)的投資決策之中,它是隨機(jī)決策模型中最常見(jiàn)、最普及的一種規(guī)策模式和方法,能有效地控制決策帶來(lái)的風(fēng)險(xiǎn)[1]。決策樹(shù)易于理解和實(shí)現(xiàn),能同時(shí)處理數(shù)據(jù)型和常規(guī)屬性,能夠在相對(duì)短的時(shí)間內(nèi)對(duì)大型數(shù)據(jù)源做出可行且效果良好的結(jié)果[2]。線性邏輯回歸和樹(shù)歸納是兩種常用的決策樹(shù)分類方法。但線性邏輯回歸在擬合簡(jiǎn)單模型時(shí)會(huì)導(dǎo)致低方差和高偏差;而樹(shù)歸納會(huì)導(dǎo)致低偏差和高方差[3]。因此,將兩種分類方法相結(jié)合,提出邏輯模型樹(shù)方法,不僅能分類,而且能得到類概率估計(jì), 能夠直接體現(xiàn)數(shù)據(jù)的特點(diǎn),并且參數(shù)少,應(yīng)用方便,模型準(zhǔn)確度較高。

鑒于LMT算法的以上優(yōu)點(diǎn),研究將其應(yīng)用在煙草企業(yè)煙葉綜合質(zhì)量評(píng)價(jià)中。目前,在煙草企業(yè)中,煙葉的質(zhì)量主要根據(jù)化學(xué)成分值和評(píng)吸專家的評(píng)吸來(lái)綜合判定。在判定過(guò)程中,各位專家要經(jīng)過(guò)反復(fù)討論來(lái)判定每種煙葉的質(zhì)量層次,以便煙草原料研究人員在配方使用前對(duì)煙葉進(jìn)行初步篩選。為減少煙葉質(zhì)量層次判定的討論時(shí)間,本文利用改進(jìn)的LMT算法對(duì)煙葉數(shù)據(jù)進(jìn)行建模并預(yù)測(cè)煙葉的質(zhì)量層次。在實(shí)際應(yīng)用中,提高了煙草原料研究人員的工作效率。

1 LMT算法基本原理

1.1 LMT簡(jiǎn)介

LMT算法是由Niels Landwehr、Mark Hall 和 Eibe Frank在2003年第十四屆關(guān)于機(jī)器學(xué)習(xí)歐洲會(huì)議上提出的[4]。邏輯模型樹(shù)是由葉子上帶有邏輯回歸函數(shù)的標(biāo)準(zhǔn)決策樹(shù)結(jié)構(gòu)構(gòu)成的。這個(gè)方法采用LogitBoost算法在樹(shù)的節(jié)點(diǎn)上建立邏輯回歸函數(shù)[5],并使用CART算法進(jìn)行剪枝[6]。本文利用AIC準(zhǔn)則改進(jìn)LMT算法[7],以減少?zèng)Q策樹(shù)的邏輯回歸模型的計(jì)算復(fù)雜度,從而減少訓(xùn)練時(shí)間。

1.2 LogitBoost算法

Logitboost算法是改進(jìn)的Boosting算法。其基本思想是:基于現(xiàn)有樣本數(shù)據(jù)集構(gòu)建一個(gè)基礎(chǔ)的“弱分類器”,反復(fù)調(diào)用該“弱分類器”,通過(guò)對(duì)每輪中錯(cuò)判的樣本賦予更大的權(quán)重,使其更關(guān)注那些難判的樣本,經(jīng)過(guò)多輪循環(huán),最后采用加權(quán)的方法將各輪的“弱分類器”合成“強(qiáng)分類器”,從而得到較高精度的預(yù)測(cè)模型[8]。

1.3 CART算法

CART算法選擇具有最小基尼指數(shù)值的屬性作為測(cè)試屬性, 并采用一種二分遞歸分割技術(shù), 將當(dāng)前樣本集分為兩個(gè)子樣本集, 使得生成的決策樹(shù)的每一個(gè)非葉節(jié)點(diǎn)都有兩個(gè)分枝。最后生成的決策樹(shù)是結(jié)構(gòu)簡(jiǎn)潔的二叉樹(shù),用獨(dú)立的驗(yàn)證數(shù)據(jù)集對(duì)訓(xùn)練集生長(zhǎng)的樹(shù)進(jìn)行剪枝,不易產(chǎn)生數(shù)據(jù)碎片。CART剪枝算法使用獨(dú)立于訓(xùn)練樣本集的測(cè)試樣本集對(duì)子樹(shù)的分類錯(cuò)誤進(jìn)行計(jì)算, 找出分類錯(cuò)誤最小的子樹(shù)作為最終的分類模型[9]。

1.4 LMT算法步驟

LMT算法步驟描述如下:

⑴ 建立根節(jié)點(diǎn);

⑵ 建立邏輯模型樹(shù):

① 初始化

權(quán)重Wij=1/n,i=1,…,n,j=1,…,J

分類器Fj(x)=0;概率估計(jì)pj(x)=1/J

② 利用五折交叉驗(yàn)證得到最佳迭代次數(shù)M

③ 進(jìn)行迭代, m=1,…,M

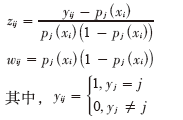

a.分別計(jì)算作業(yè)應(yīng)變量和權(quán)重

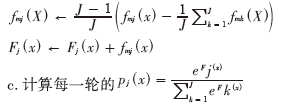

b.采用加權(quán)最小二乘法擬合弱分類器函數(shù)fmj(X) :

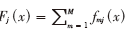

c.計(jì)算每一輪的

④ 輸出最終的分類器 ,根據(jù)正負(fù)對(duì)樣品判別歸類;

,根據(jù)正負(fù)對(duì)樣品判別歸類;

⑶ 繼續(xù)分裂樣本,并對(duì)分裂樣本的數(shù)據(jù)子集再重復(fù)步驟⑵建樹(shù),直至停止分裂;

⑷ 利用CART算法對(duì)其進(jìn)行修剪。

1.5 AIC準(zhǔn)則

本研究中使用泛化誤差的樣本內(nèi)估計(jì)赤池信息量準(zhǔn)則來(lái)替換原算法中交叉驗(yàn)證選取最佳迭代次數(shù)來(lái)改進(jìn)LMT算法[10]。赤池信息量準(zhǔn)則(Akaike Information Criterion),又稱為AIC準(zhǔn)則。赤池建議,當(dāng)欲從一組可供選擇的模型中選擇一個(gè)最佳模型時(shí),可選擇AIC為最小的模型。赤池信息量準(zhǔn)則的方法是尋找可以最好地解釋數(shù)據(jù)但包含最少自由參數(shù)的模型[11]。

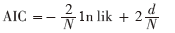

AIC提供了當(dāng)使用可能性損失函數(shù)時(shí)的泛化誤差估計(jì),其定義為:

missing image file

其中,d是迭代次數(shù),lik為模型的極大似然函數(shù),N是訓(xùn)練實(shí)例個(gè)數(shù)。隨著d的增長(zhǎng),等式的第一項(xiàng)下降(因?yàn)長(zhǎng)ogitBoost完成擬牛頓算法,接近最大似然函數(shù)對(duì)數(shù)),第二項(xiàng)總是會(huì)增加。因此,選最佳迭代次數(shù)是最小化AIC時(shí)的迭代次數(shù)d。

使用AIC標(biāo)準(zhǔn)來(lái)防止模型過(guò)度擬合,訓(xùn)練時(shí)間比原LMT算法快很多[7]。研究中默認(rèn)AIC最小迭代是50次。

2 實(shí)驗(yàn)分析

2.1 分析環(huán)境

研究利用Weka軟件對(duì)數(shù)據(jù)進(jìn)行建模。Weka的全名是懷卡托智能分析環(huán)境,是一款免費(fèi)的、非商業(yè)化的、基于JAVA環(huán)境的開(kāi)源機(jī)器學(xué)習(xí)以及數(shù)據(jù)挖掘軟件。Weka作為一個(gè)公開(kāi)的數(shù)據(jù)挖掘工作平臺(tái),集合了大量能承擔(dān)數(shù)據(jù)挖掘任務(wù)的機(jī)器學(xué)習(xí)算法,包括對(duì)數(shù)據(jù)進(jìn)行預(yù)處理、分類、回歸、聚類、關(guān)聯(lián)規(guī)則以及在新的交互式界面上的可視化[12]。

2.2 數(shù)據(jù)描述

UCI標(biāo)準(zhǔn)數(shù)據(jù)集:UCI數(shù)據(jù)庫(kù)是加州大學(xué)歐文分校提出的用于機(jī)器學(xué)習(xí)的數(shù)據(jù)庫(kù),這個(gè)數(shù)據(jù)庫(kù)目前共有187個(gè)數(shù)據(jù)集,其數(shù)目還在不斷增加,UCI數(shù)據(jù)集是一個(gè)常用的標(biāo)準(zhǔn)測(cè)試數(shù)據(jù)集,從中挑選iris、segment、glass三個(gè)標(biāo)準(zhǔn)數(shù)據(jù)集進(jìn)行建模預(yù)測(cè)。

煙葉數(shù)據(jù):該煙葉實(shí)驗(yàn)數(shù)據(jù)由全國(guó)各省不同等級(jí)的入庫(kù)煙葉組成,包括產(chǎn)地、等級(jí)、質(zhì)量層次、各化學(xué)成分值和各感官評(píng)價(jià)分?jǐn)?shù)等,其中質(zhì)量層次數(shù)據(jù)是各位專家根據(jù)經(jīng)驗(yàn)和評(píng)吸情況通過(guò)共同討論綜合決定的。實(shí)驗(yàn)中,訓(xùn)練建模數(shù)據(jù)選擇全國(guó)各省數(shù)據(jù)355條,測(cè)試數(shù)據(jù)分別選擇云南省上部煙數(shù)據(jù)16條、云南省中部煙數(shù)據(jù)28條。

2.3 實(shí)驗(yàn)步驟

針對(duì)UCI標(biāo)準(zhǔn)數(shù)據(jù)集,分別用LMT算法及其他決策樹(shù)對(duì)比算法建模,對(duì)結(jié)果進(jìn)行比較分析,然后用改進(jìn)的LMT算法對(duì)數(shù)據(jù)集進(jìn)行建模,與原LMT算法結(jié)果進(jìn)行對(duì)比分析。

針對(duì)煙葉數(shù)據(jù),首先剔除含有缺失值的煙葉,然后對(duì)輸出屬性數(shù)據(jù)即質(zhì)量層次數(shù)據(jù)進(jìn)行離散化,由于有多種描述煙葉各方面的指標(biāo),本研究通過(guò)特征指標(biāo)選擇,選取施木克值、總糖、雜氣、香氣質(zhì)、余味、香氣量、刺激性、濕潤(rùn)程度作為建模特征指標(biāo)數(shù)據(jù),最后利用改進(jìn)的LMT算法對(duì)其建模預(yù)測(cè),并分析結(jié)果。

2.4 實(shí)驗(yàn)驗(yàn)證

實(shí)驗(yàn)一:不同的算法在UCI標(biāo)準(zhǔn)數(shù)據(jù)集中的結(jié)果

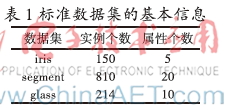

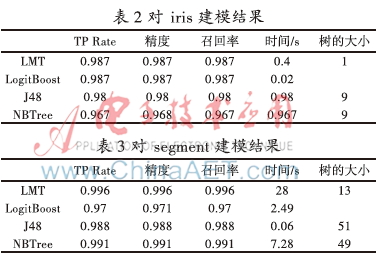

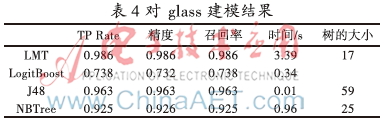

取iris、segment、glass 3個(gè)不同的標(biāo)準(zhǔn)數(shù)據(jù)集,數(shù)據(jù)集的信息如表1所示。對(duì)3個(gè)標(biāo)準(zhǔn)數(shù)據(jù)集分別用LMT、Logistic、J48、NBTree 4種算法進(jìn)行建模分類,其性能結(jié)果分別如表2、表3、表4所示。

從表2、表3、表4中可以看出,LMT算法的TP Rate、精度、召回率均比LogitBoost、J48、NBTree算法高,而且LMT建模的樹(shù)規(guī)模最小,說(shuō)明LMT算法在保證建模準(zhǔn)確率的前提下,通過(guò)邏輯模型使樹(shù)更易被解釋,但缺點(diǎn)是由于計(jì)算復(fù)雜度高導(dǎo)致耗時(shí)過(guò)長(zhǎng)。針對(duì)這一問(wèn)題,利用AIC準(zhǔn)則對(duì)LMT算法改進(jìn),提高時(shí)間性能。

實(shí)驗(yàn)二: AIC準(zhǔn)則對(duì)LMT算法的影響

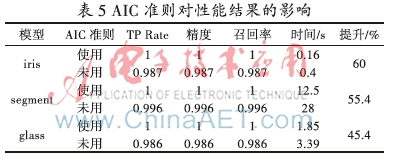

針對(duì)3個(gè)UCI標(biāo)準(zhǔn)數(shù)據(jù)集,使用AIC準(zhǔn)則和不使用AIC準(zhǔn)則分別進(jìn)行建模,其性能結(jié)果如表5所示。

從表5中可以看出,使用AIC準(zhǔn)則后,對(duì)3個(gè)數(shù)據(jù)集進(jìn)行建模,TP Rate、精度、召回率、時(shí)間性能均有不同幅度的提升,說(shuō)明使用AIC準(zhǔn)則可以對(duì)LMT算法進(jìn)行有效的改進(jìn)。

實(shí)驗(yàn)三:利用改進(jìn)的LMT算法對(duì)煙葉數(shù)據(jù)進(jìn)行建模預(yù)測(cè)

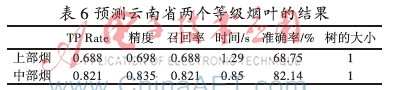

先用NBTree算法對(duì)355條全國(guó)各省不同等級(jí)煙葉的化學(xué)成分?jǐn)?shù)據(jù)和評(píng)吸質(zhì)量分?jǐn)?shù)來(lái)建模,模型的精度和時(shí)間性能結(jié)果并不理想。再用改進(jìn)的LMT算法對(duì)煙葉數(shù)據(jù)建模,然后利用模型分別將16條云南省上部煙數(shù)據(jù)、28條云南省中部煙數(shù)據(jù)對(duì)各煙葉的質(zhì)量層次進(jìn)行預(yù)測(cè),其結(jié)果如表6所示。

從表6中可以看出,改進(jìn)的LMT算法對(duì)云南省的兩個(gè)部位的煙葉預(yù)測(cè)結(jié)果較為理想。由于質(zhì)量層次數(shù)據(jù)是由專家討論綜合決定,存在一定的人為因素,所以準(zhǔn)確率較標(biāo)準(zhǔn)數(shù)據(jù)集略低,但在實(shí)際應(yīng)用中,該算法建模預(yù)測(cè)能較好地評(píng)價(jià)煙葉綜合質(zhì)量。因?yàn)橹胁繜煍?shù)據(jù)量多,建立的模型更加完備,因此預(yù)測(cè)較上部煙更為準(zhǔn)確。

3 結(jié)束語(yǔ)

本文介紹了LMT算法的基本原理,針對(duì)LMT算法的時(shí)間性能問(wèn)題,利用AIC準(zhǔn)則通過(guò)改進(jìn)選取最佳迭代次數(shù)的方式,使時(shí)間性能大幅度提升。通過(guò)對(duì)比LMT算法與其他算法對(duì)標(biāo)準(zhǔn)數(shù)據(jù)集建模的結(jié)果發(fā)現(xiàn),LMT算法在模型精度上優(yōu)于其他算法,模型精度高,結(jié)果易于解釋,并且改進(jìn)的LMT算法使時(shí)間性能提升50%左右。使用改進(jìn)的LMT算法對(duì)煙葉數(shù)據(jù)建模預(yù)測(cè),結(jié)果表明改進(jìn)的LMT算法對(duì)模型的準(zhǔn)確率有相應(yīng)的提高,而且能夠有效地提高時(shí)間性能。實(shí)驗(yàn)表明改進(jìn)的LMT算法較其他算法更適用于評(píng)價(jià)煙葉綜合質(zhì)量。該模型在企業(yè)實(shí)際應(yīng)用的結(jié)果表明,可以在入庫(kù)片煙質(zhì)量評(píng)價(jià)過(guò)程中快速、有效地依據(jù)化學(xué)成分和感官指標(biāo)判定煙葉的綜合質(zhì)量,減少專家評(píng)吸次數(shù),并且為原料在不同檔次卷煙配方中的可用性提供信息支撐。

參考文獻(xiàn)

[1] 田苗苗. 數(shù)據(jù)挖掘之決策樹(shù)方法概述[J]. 長(zhǎng)春大學(xué)學(xué)報(bào), 2005,14(6): 48-51.

[2] 陳誠(chéng). 基于AFS理論的模糊分類器設(shè)計(jì)[D]. 大連:大連理工大學(xué), 2009.

[3] Perlich C, Provost F, Simonoff J S. Tree induction vs. logistic regression: a learning-curve analysis[J]. The Journal of Machine Learning Research, 2003, (4): 211-255.

[4] Landwehr N, Hall M, Frank E. Logistic model trees[J]. Machine Learning, 2005, 59(1/2):161-205.

[5] Friedman J, Hastie T, Tibshirani R. Special invited paper. additive logistic regression: A statistical view of boosting[J]. Annals of statistics, 2000,28(2): 337-374.

[6] Breiman L, Friedman H, Olshen J A. Classification and Regression Trees[M]. New York:Wadsworth,1984.

[7] Sumner M, Frank E, Hall M. Speeding up logistic model tree induction[M].Knowledge Discovery in Databases: PKDD 2005, Springer Berlin Heidelberg, 2005.

[8] 富春楓,荀鵬程,趙楊,等. logitboost 及其在判別分析中的應(yīng)用[J]. 中國(guó)衛(wèi)生統(tǒng)計(jì), 2006,23(2):98-100.

[9] 季桂樹(shù),陳沛玲,宋航. 決策樹(shù)分類算法研究綜述[J]. 科技廣場(chǎng), 2007(1):9-12.

[10] Akaike H. Information theory and an extension of the maximum likelihood principle[M].Breakthroughs in statistics, Springer New York, 1992.

[11] De Ridder F, Pintelon R, Schoukens J, et al. Modified AIC and MDL model selection criteria for short data records[J]. Instrumentation and Measurement, IEEE Transactions on, 2005, 54(1): 144-150.

[12] 陸遠(yuǎn)蓉. 使用數(shù)據(jù)挖掘工具Weka[J]. 電腦知識(shí)與技術(shù), 2008,1(6):988-993.